DeepSeek作为一个开源的AI大模型,怎么把它落地到我们本地,然后使用我们自己本地的数据来训练,在诊所日常的工作中帮到我们呢?

在这个乙巳蛇年的春节假期,笔者试着把DeepSeek r1 14b模型部署到了自己的笔记本上,然后借助AnythingLLM把手头的一些资料喂了进去,得到了比较满意的结果。在此抛砖引玉,希望能对您经营诊所有所帮助。

Deep SeeK是成立于2023年7月份的杭州深度求索人工智能基础技术研究有限公司推出的新一代的开源大语言模型(LLM,Large Language Model),2024年11月20日,DeepSeek-R1-Lite预览版正式上线。2025年1月20日,深度求索(DeepSeek)正式发布DeepSeek-R1模型,并同步开源模型。

基本介绍

DeepSeek-R1-Lite预览版模型在美国数学竞赛(AMC)中难度等级最高的AIME以及全球顶级编程竞赛(codeforces)等评测中,超越了GPT-4o等模型。

DeepSeek-R1在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩OpenAI o1正式版。

DeepSeek-R1的一大技术亮点在于其采用了大规模强化学习(RL)进行后训练。这项技术仅需少量标注数据,即可显著提升模型的性能,为大型语言模型的训练提供了新的思路。DeepSeek在开源DeepSeek-R1-Zero和DeepSeek-R1两个660B模型的同时,通过DeepSeek-R1的输出,蒸馏了 6 个小模型开源给社区,其中 32B和 70B模型在多项能力上实现了对标OpenAI o1-mini的效果。

相关评价:

DeepSeek从V3到R1,将进一步推动全行业大模型的提升,更快地追赶GPT-4o和GPT-o1;同时成本的下降,有助于AI应用和AI终端的普及。(华泰证券研报 评)

中国人工智能初创公司DeepSeek的崛起应当为美国企业敲响“警钟”,美国公司“需要专注于竞争以赢得胜利。DeepSeek崛起也可能传递了一种积极信号。(美国总统特朗普 评)

中国DeepSeek AI模型超越了美国,中国科学家在人工智能(AI)领域取得的成就,以及包括DeepSeek的出现,超越了美国相关研发人员在该领域的成果。(俄罗斯外交部长拉夫罗夫 评)

DeepSeek-R1是一款使人印象深刻的模型,尤其是考虑到它能够以这个价格提供这样的产品。有这样的新竞争对手确实令人振奋。(美国开放人工智能研究中心首席执行官萨姆·奥尔特曼 评)

这么好的一个产品,网上也是热闹非凡,怎么能帮到诊所呢?我们一步一步的来,基本思路如下:

-

-

-

- 安装Ollama软件,搭建DeepSeek的工作环境;

- 下载并安装对应版本的DeepSeek r1模型软件;

- 安装AnythingLLM软件;

- 导入日常工作文档,完成模型训练;

- 离线使用。

步骤一、安装Ollama软件,搭建DeepSeek的工作环境

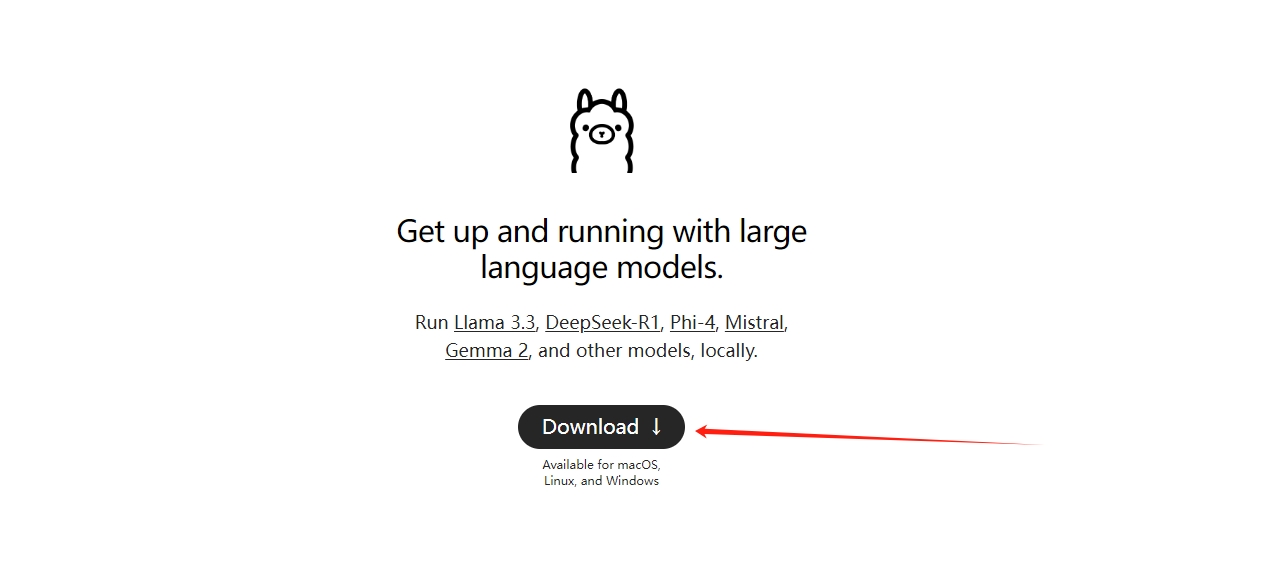

从Ollama网站(https://ollama.com/)下载并安装。直接点击下图中的“Download”,网站会跳转到安装包下载页面。

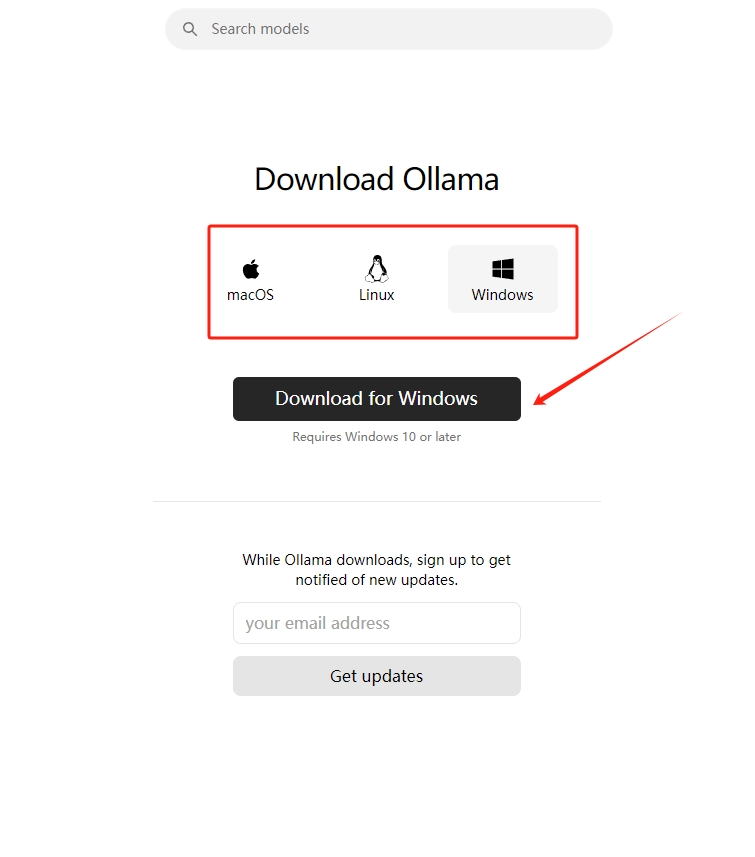

网站会根据探测到的操作系统版本,自动给我们推送对应的版本(如下图红框中),一般我们使用Windows版本,也推荐使用Windows电脑来操作。为什么不推荐苹果?因为它的硬件太贵了,一般用的苹果机跑不动大模型,下边会提。

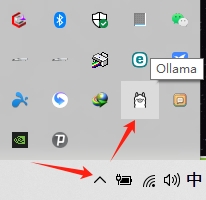

下载完成后,双击安装包安装,根据引导,点击下一步直到安装成功。点击电脑右下角箭头所示位置,检查是否出现Ollama的羊驼图标。如果出现表示安装成功。

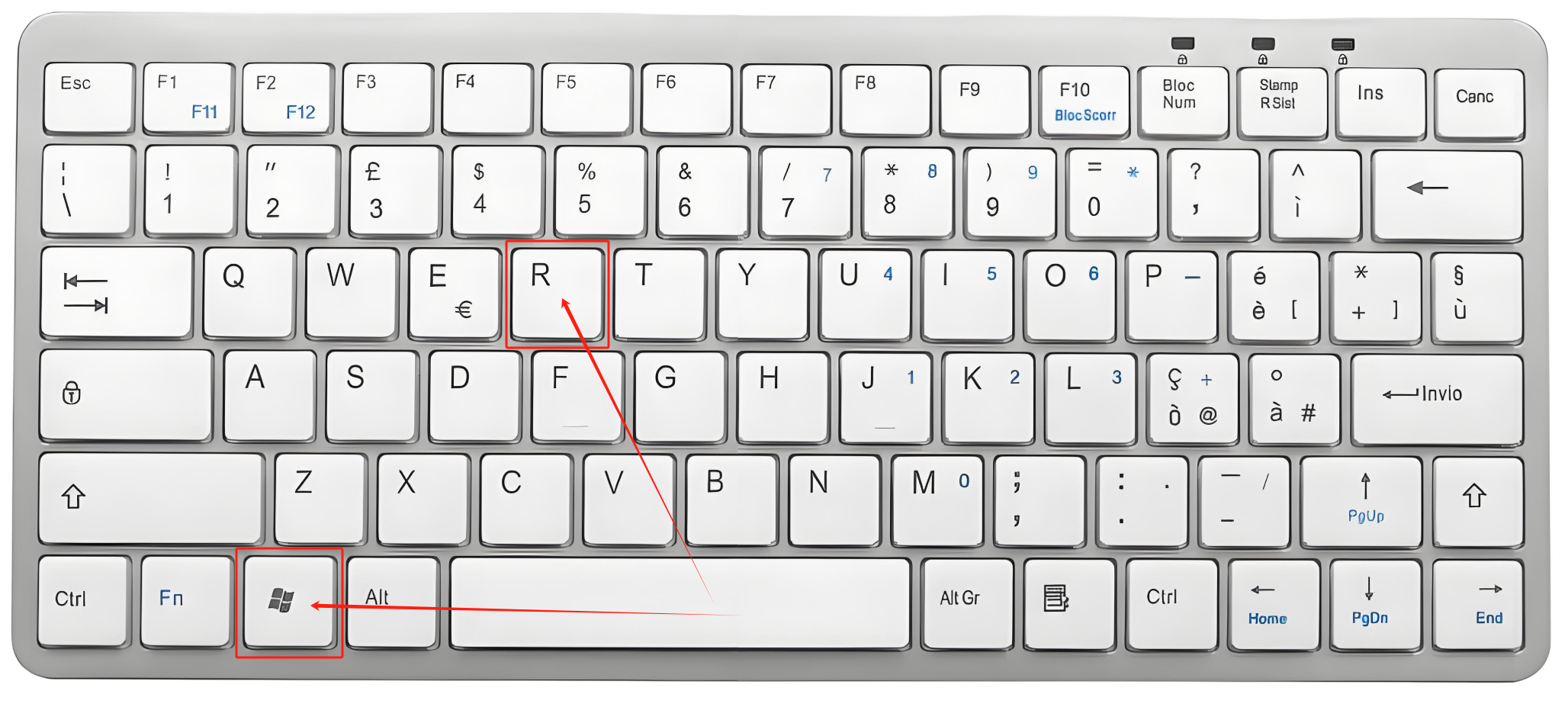

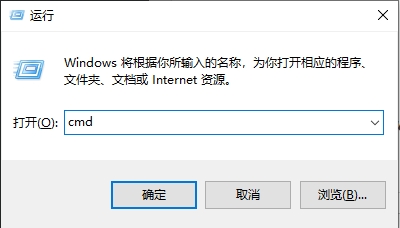

我们再检查一下是否功能正常。同时点击键盘的windows键(田字键)和R键,如下图箭头和方框所示。

在跳出的窗口内输入“CMD”(不含引号,大小写均可),然后点击回车键(键盘上的“Enter”键)或者点击下图的“确认”。

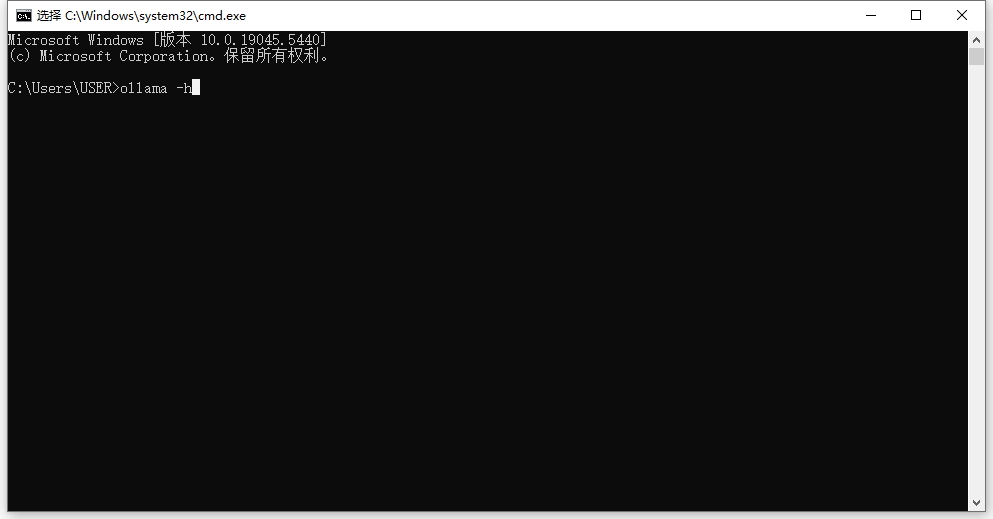

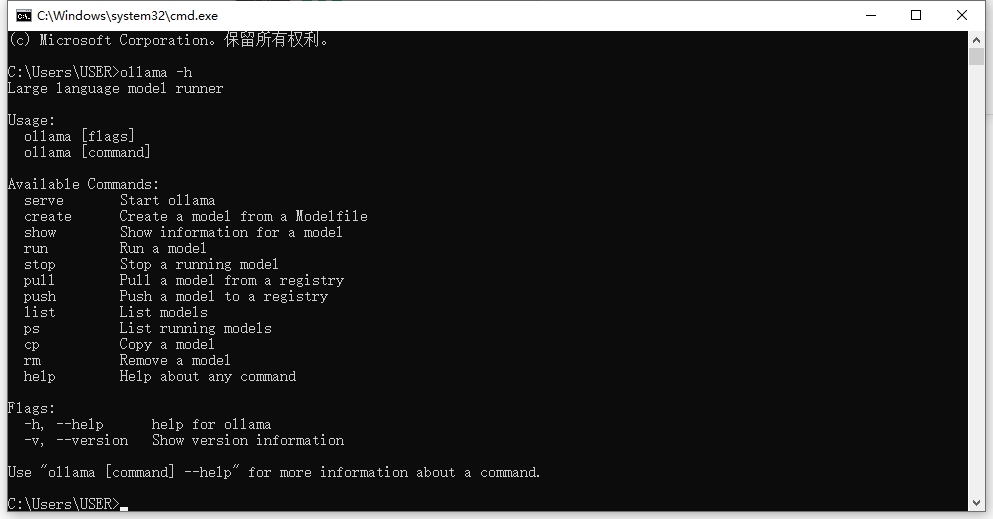

在跳出的cmd终端内输入:

ollama -h

如下图所示,然后点击回车

如果跳出的内容和下图一致,那么说明安装的Ollama功能正常,可以进入第二步了。

步骤二、下载并安装对应版本的DeepSeek r1模型软件

目前可用的DeepSeek版本和对应的硬件要求如下:

| 版本名称 |

软件体积 |

电脑配置及应用场景 |

| 1.5b |

1.1GB |

-

- CPU: 最低 4 核(推荐 Intel/AMD 多核处理器)

- 内存: 8GB+

- 硬盘: 3GB+ 存储空间(模型文件约 1.5-2GB)

- 显卡: 非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650)

- 场景:

- 低资源设备部署(如树莓派、旧款笔记本)

- 实时文本生成(聊天机器人、简单问答)

- 嵌入式系统或物联网设备

|

| 7b |

4.7GB |

-

- CPU: 8 核以上(推荐现代多核 CPU)

- 内存: 16GB+

- 硬盘: 8GB+(模型文件约 4-5GB)

- 显卡: 推荐 8GB+ 显存(如 RTX 3070/4060)

- 场景:

- 本地开发测试(中小型企业)

- 中等复杂度 NLP 任务(文本摘要、翻译)

- 轻量级多轮对话系统

|

| 8b |

4.9GB |

-

- 硬件需求: 与 7B 相近,略高 10-20%

- 场景:

- 需更高精度的轻量级任务(如代码生成、逻辑推理)

|

| 14b |

9.0GB |

-

- CPU: 12 核以上

- 内存: 32GB+

- 硬盘: 15GB+

- 显卡: 16GB+ 显存(如 RTX 4090 或 A5000)

- 场景:

- 企业级复杂任务(合同分析、报告生成)

- 长文本理解与生成(书籍/论文辅助写作)

|

| 32b |

20GB |

-

- CPU: 16 核以上(如 AMD Ryzen 9 或 Intel i9)

- 内存: 64GB+

- 硬盘: 30GB+

- 显卡: 24GB+ 显存(如 A100 40GB 或双卡 RTX 3090)

- 场景:

- 高精度专业领域任务(医疗/法律咨询)

- 多模态任务预处理(需结合其他框架)

|

| 70b |

43GB |

-

- CPU: 32 核以上(服务器级 CPU)

- 内存: 128GB+

- 硬盘: 70GB+

- 显卡: 多卡并行(如 2x A100 80GB 或 4x RTX 4090)

- 场景:

- 科研机构/大型企业(金融预测、大规模数据分析)

- 高复杂度生成任务(创意写作、算法设计)

|

| 671b |

404GB |

CPU: 64 核以上(服务器集群)

内存: 512GB+

硬盘: 300GB+

显卡: 多节点分布式训练(如 8x A100/H100)

场景:

国家级/超大规模 AI 研究(如气候建模、基因组分析)

通用人工智能(AGI)探索 |

我的笔记本电脑配置和安装软件情况,以及怎么看你手头电脑的配置?请参考下边的“常见问题2”中的方法。

如果我们准备将离线的DeepSeek大模型用来做病例管理、规章总结、制度传递、书籍整理等工作那么您使用一台和我类似配置的电脑,跑14b的模型就足够了。

下边我们开始安装大模型。

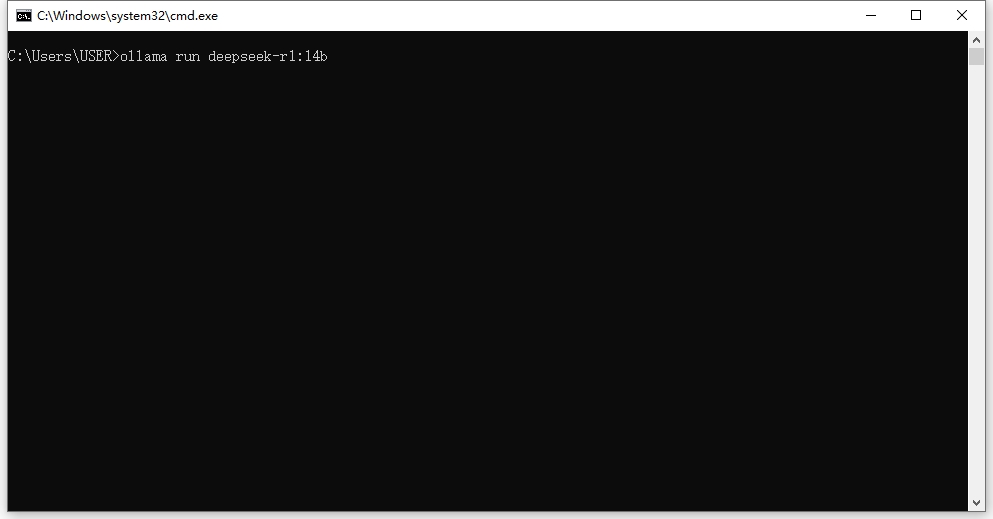

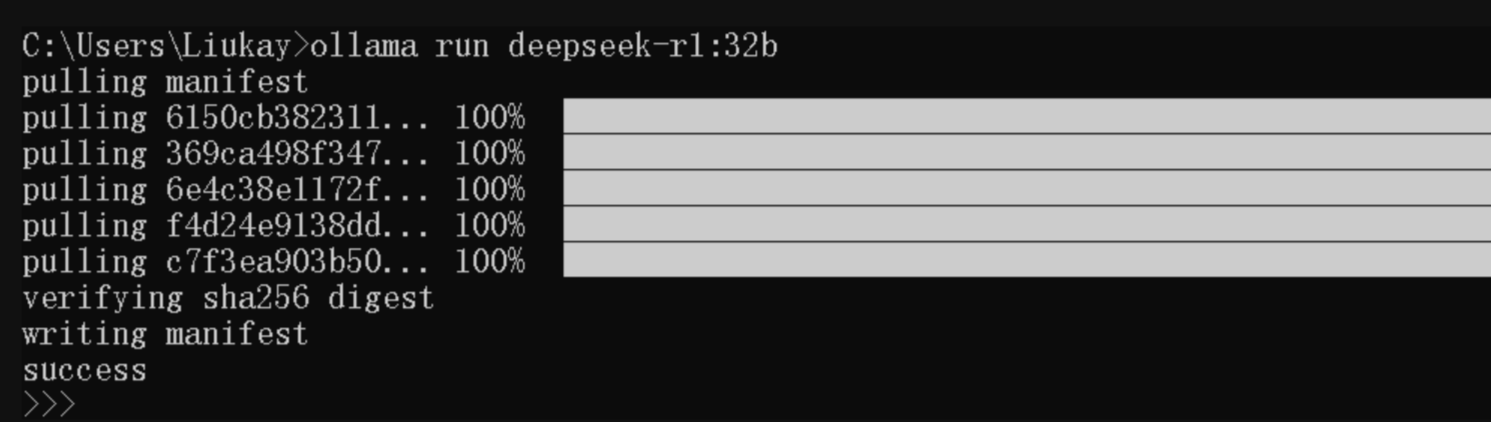

回到我们刚才的命令行窗口,输入下边的代码:

ollama run deepseek-r1:14b

然后点击回车,软件会自动帮我们下载软件。当然,您的电脑需要链接网络。

如果您的电脑屏幕开始启动,最后出现类似下图的样子就说明安装成功了。

在命令行里输入文字就可以和DeepSeek互动了。

到这Deepseek_R1大语言模型就部署完成啦,一些基本操作:

查看安装的Ollama环境,可以输入:Ollama list

开启交互,可以输入:Ollama run deepseek- r1:7b,输入要问的问题

想要退出,只要输入:/bye,就可以了啦!

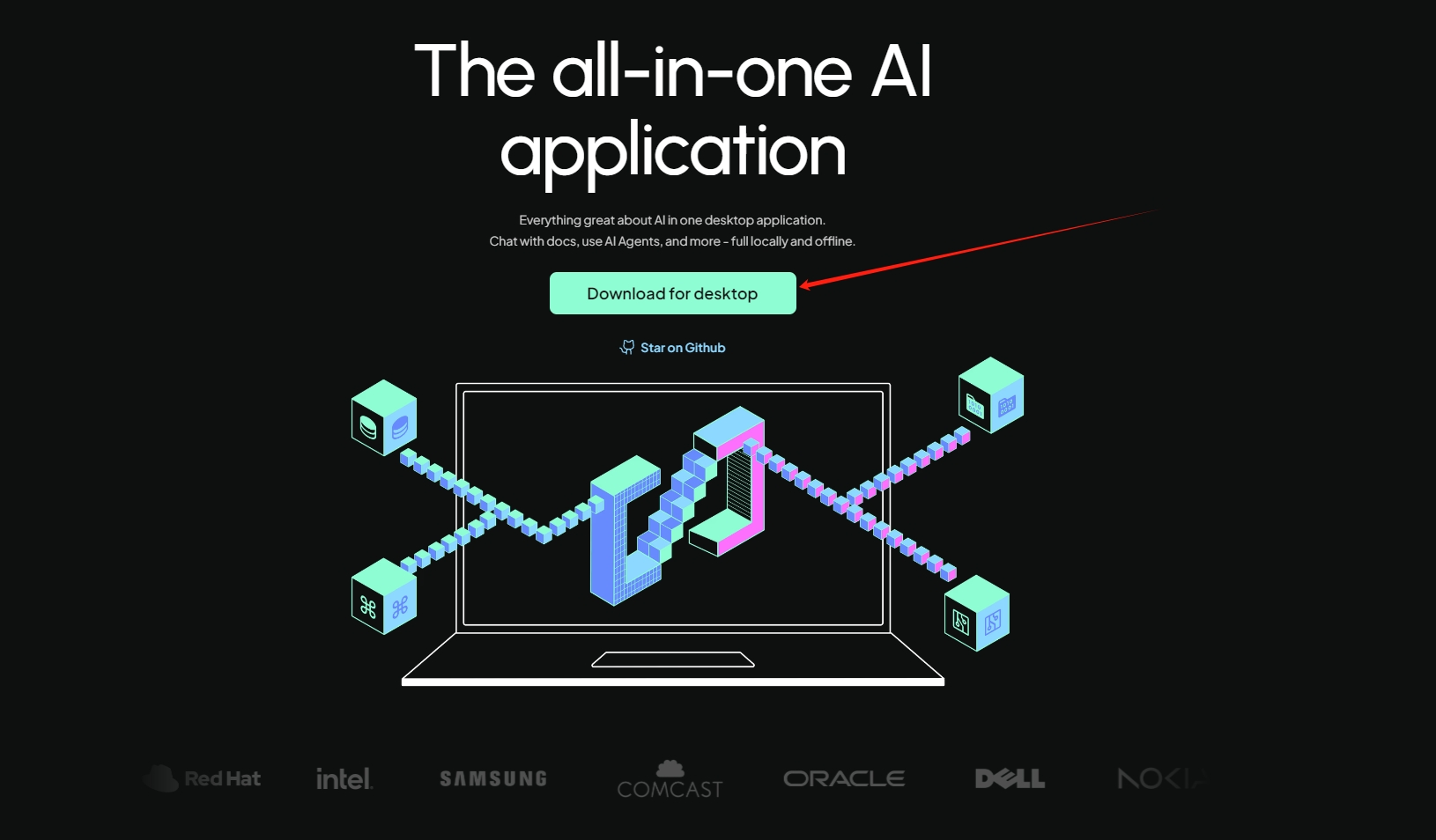

步骤三、安装AnythingLLM软件并设置

登录AnythingLLM官网(https://anythingllm.com/),点击下图箭头所示的“Download for desktop”,下载对应软件并安装到本地电脑。

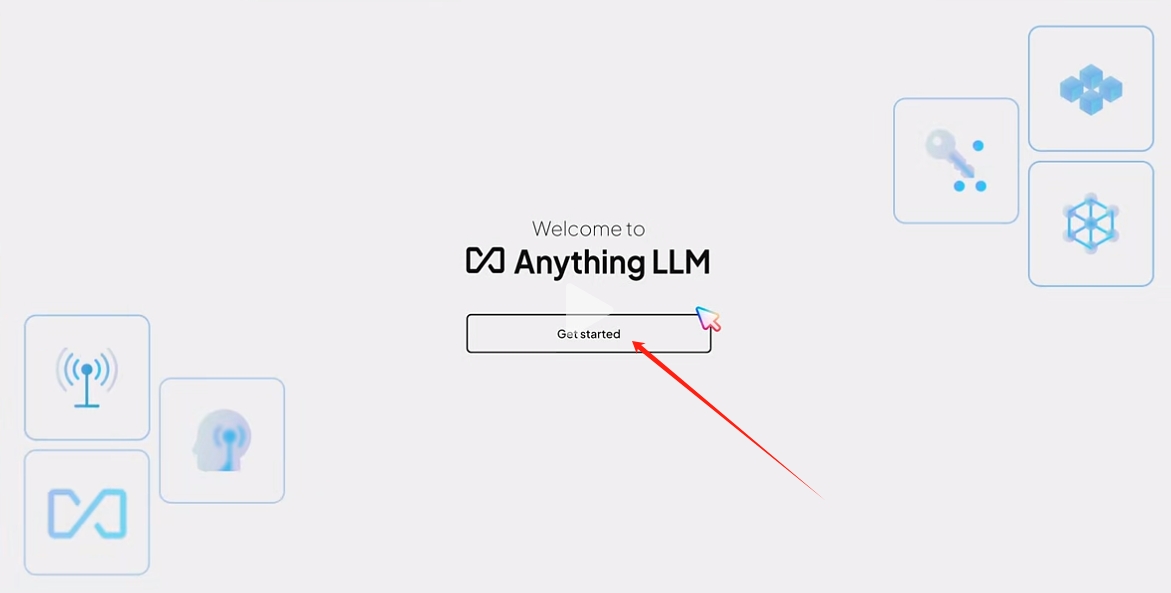

下载后,双击进行安装。安装成功,启动后如下图,点击“Get started”启动模型库。

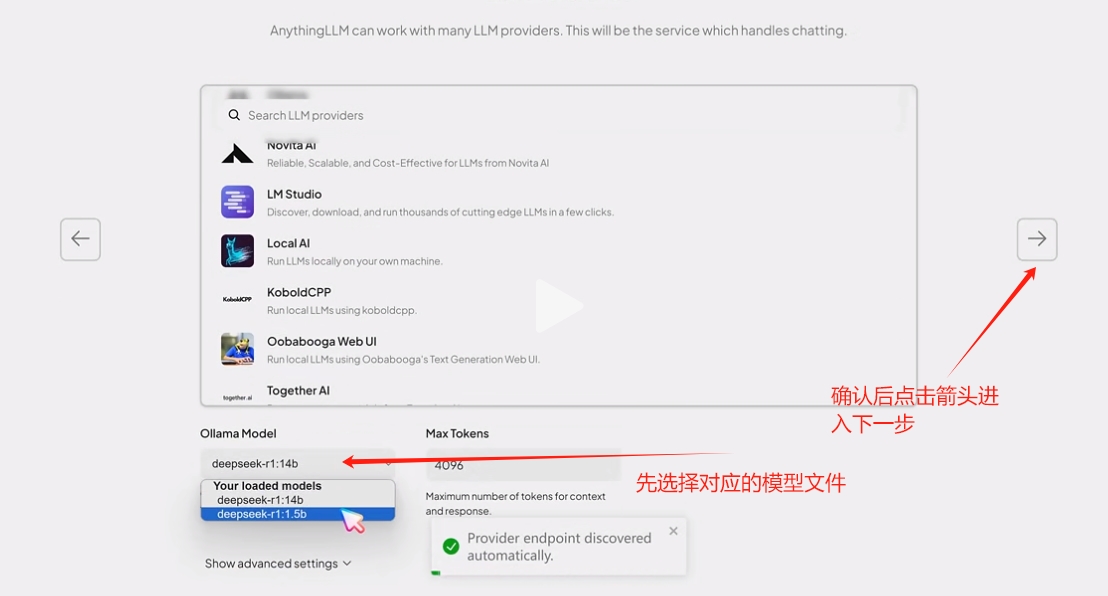

在下拉列表中选择“Ollama”。

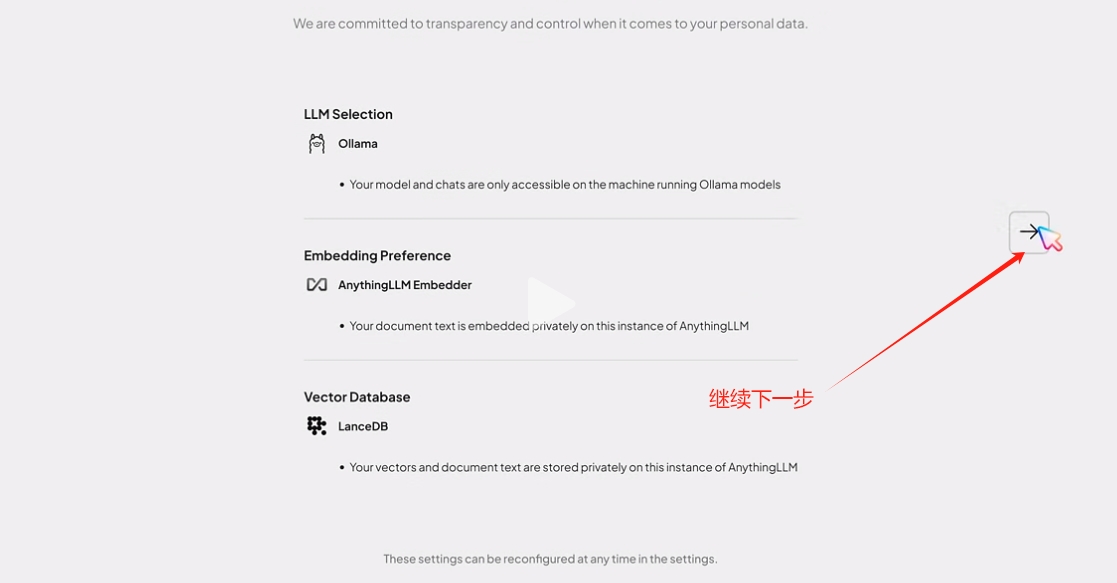

在下方确认安装的大模型版本,然后点击右侧箭头进入下一步。

继续点击下一步。

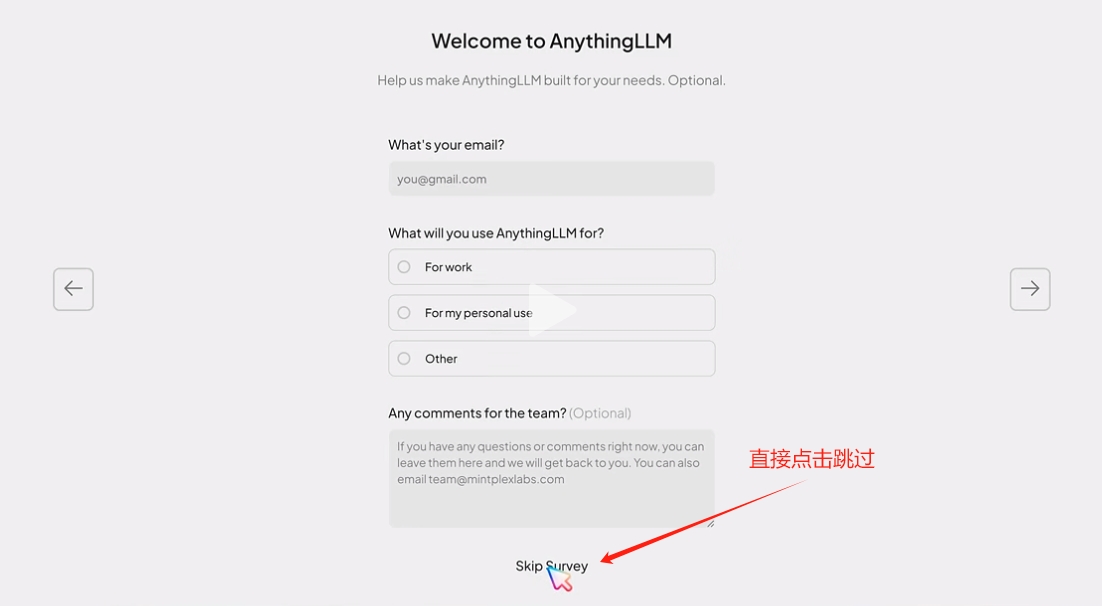

直接点击“Skip Survey”跳过。

给我们即将使用的模型取个名字,比如“学校”,然后点击右侧箭头进入下一步。

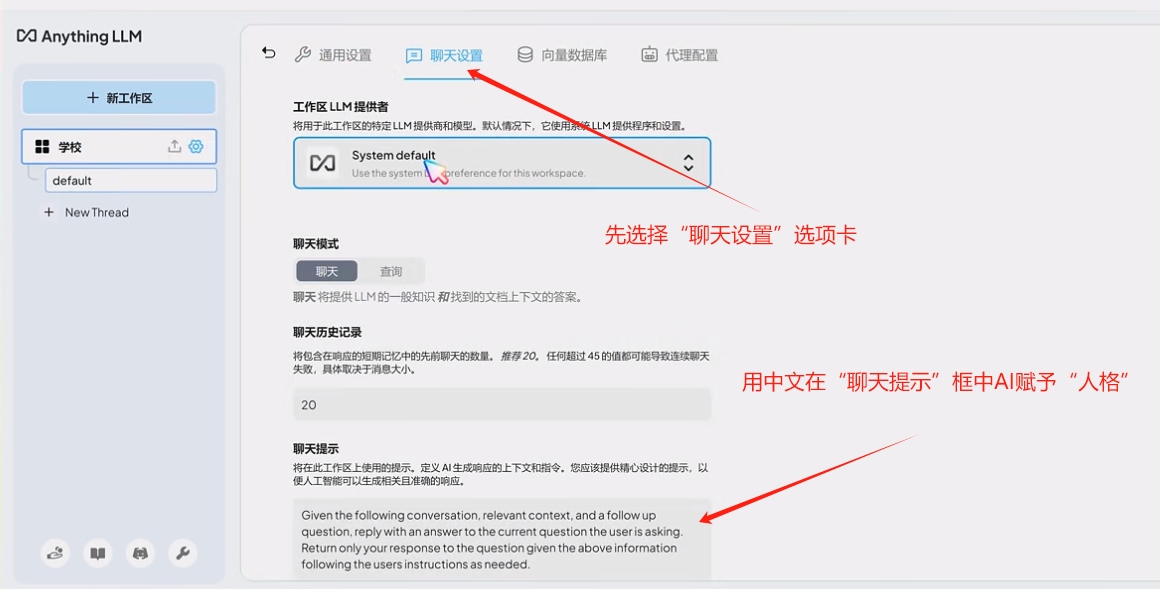

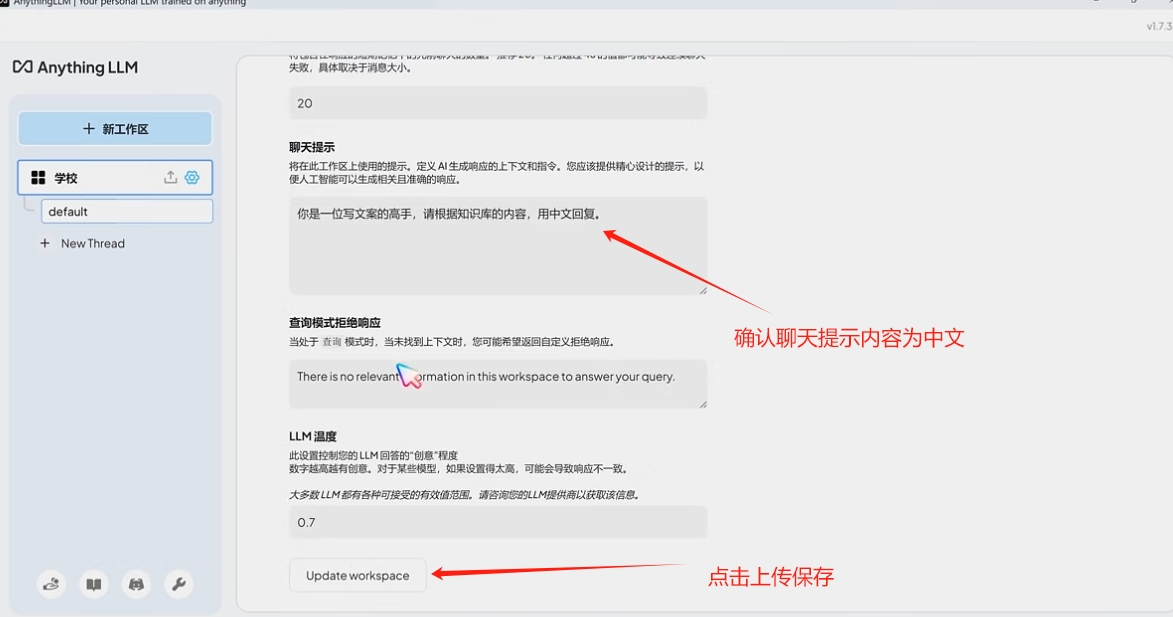

进入使用界面后,我们开始软件的设置。如下图所示,点击齿轮进入设计界面。

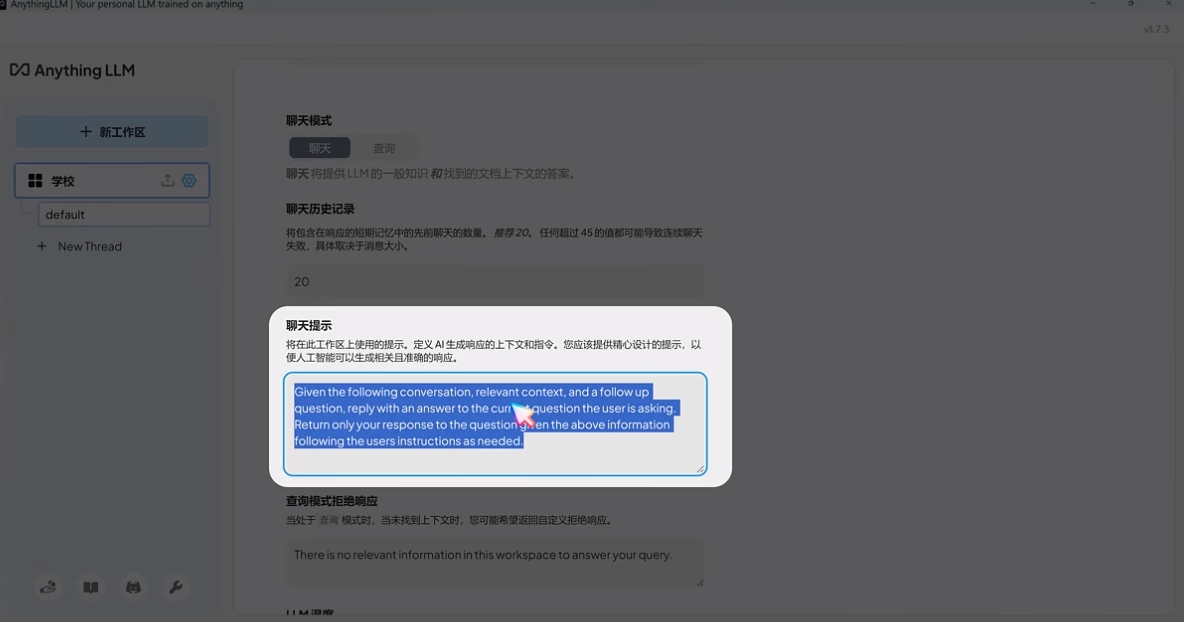

点击“聊天设置”选项卡,然后点击“聊天提示”输入你的提示词给AI赋予“人格”。

在下图提示框中输入类似“你是一位写文案的高手,根据知识库的内容,用中文回复”的内容,让AI知道他应该怎么工作。

写完后,确认聊天提示内容为中文,避免AI使用英文来回复我们的提问,然后点击“Update workapace”来上传保存设置。

步骤四、导入日常工作文档,完成模型训练

完成了以上的设置之后,我们开始对模型进行训练,让他熟悉我们诊所的日常工作,以便于任何人都可以向他提问,并获得正确的答案。

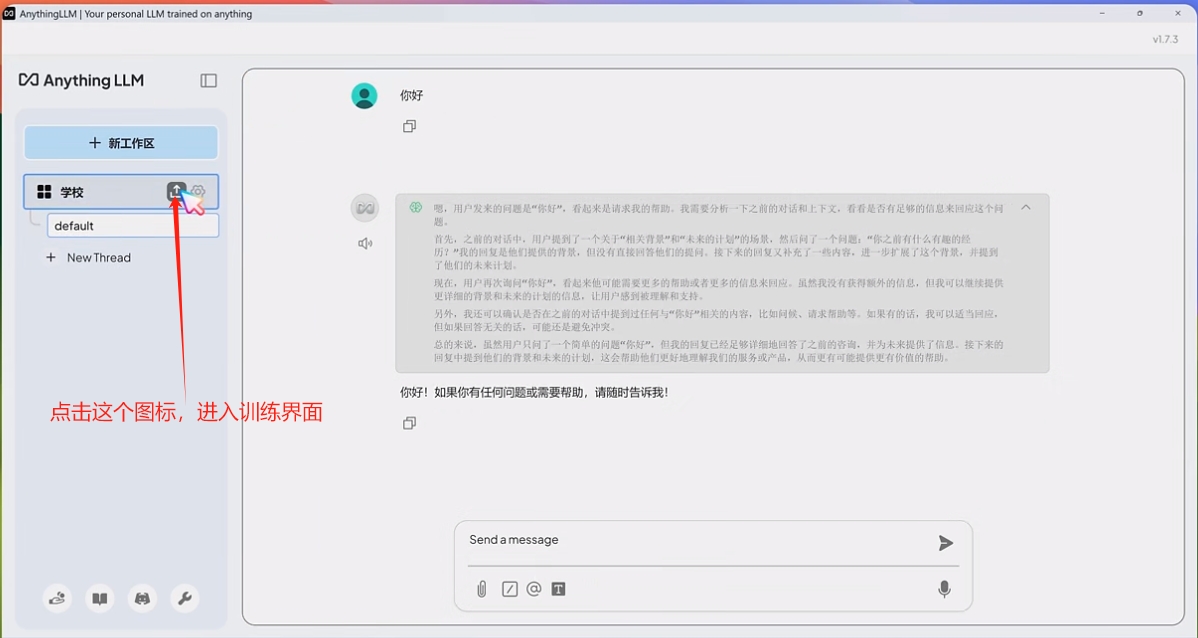

点击模型名称后边的上传图标,如下图所示。

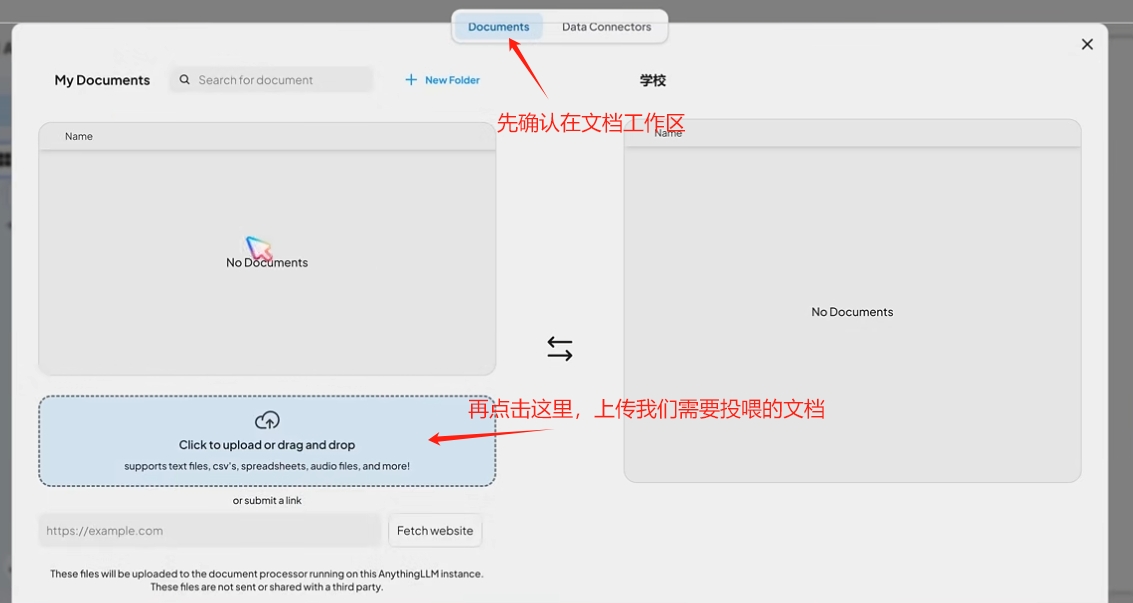

在跳转的界面中确认进入“Documents”文档工作区。点击左下方的文档上传区域,上传我们需要训练的文档。不要上传图片或者图片格式的pdf文档,目前软件还没有图像识别的功能。

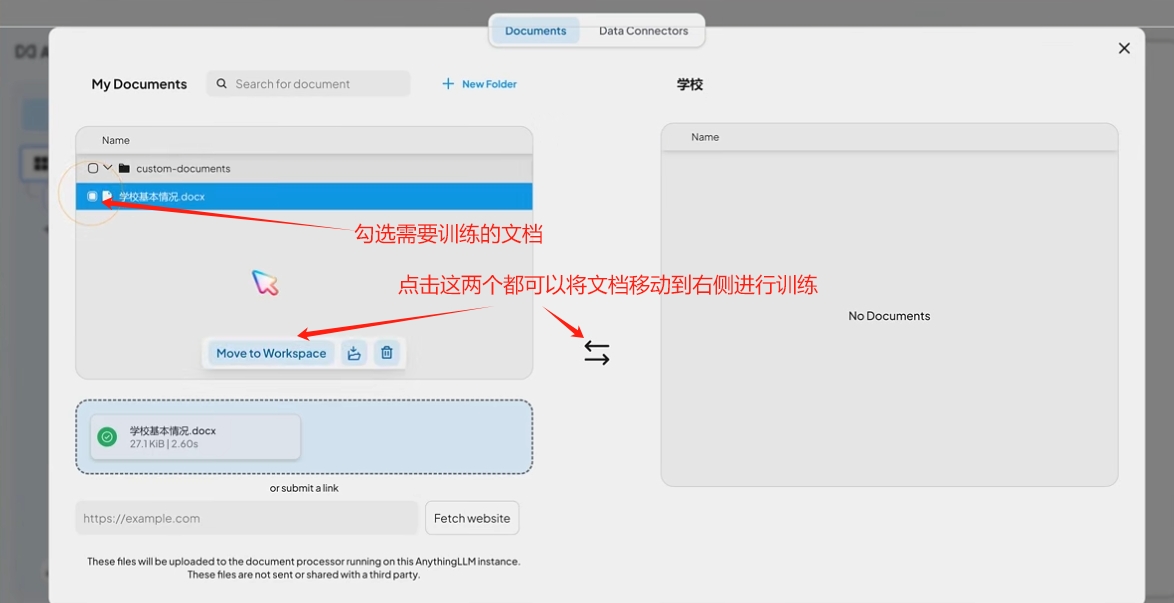

点击勾选上传的文档,然后点击将文档传输到右侧进行训练。根据文档的大小不同,电脑硬件的不同,训练完成的时间也不同。

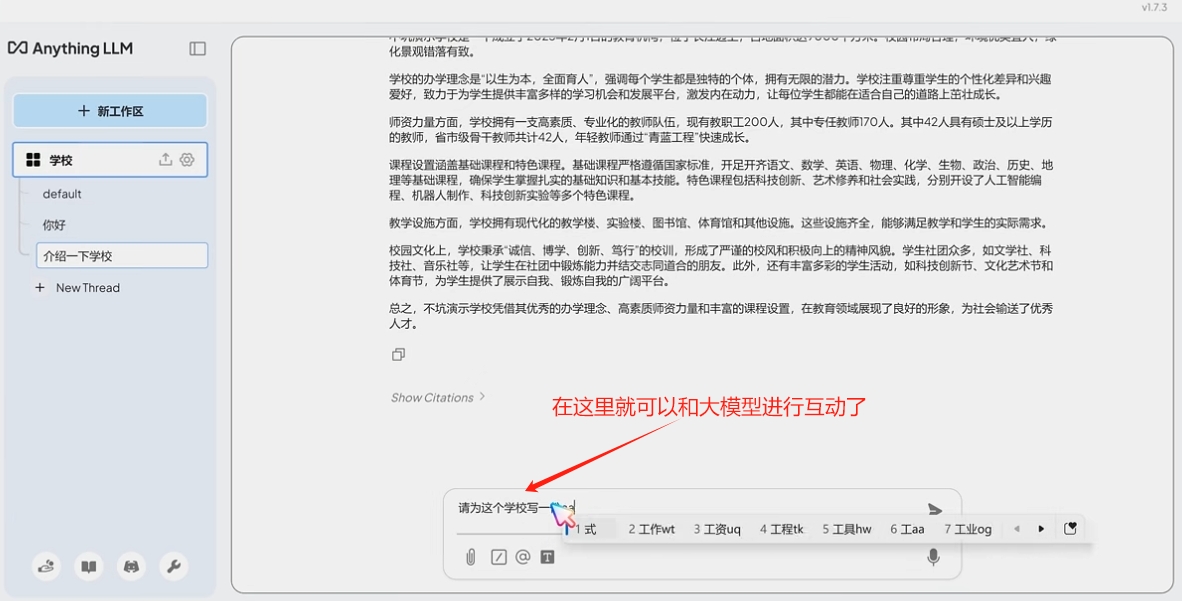

步骤五、离线使用

在完成文档的训练之后,就可以和个性化的离线DeepSeek大模型进行文字沟通了。

后续还能进行什么有趣的使用,

常见问题:

1、既然Deepseek已经有了在线版,为什么还要安装离线版的模型?

DeekSeek的网页版打开电脑联网后就可以用,但是他是选练好的模型,没有我们的行业信息,特别是针对诊所的特殊信息。比如我们的规章制度、接诊流程、常用话术技巧等需要保密的内容。离线部署的内容是可以断网使用的,相对来说信息安全有一定的保障,同时也方便流动性较大的岗位的信息浓缩和信息交接。这个时候的DeepSeek离线版就相当于我们雇佣了一个AI护士长,在不同员工间进行信息传递和信息的教授。

2、我的电脑能不能跑得动?对于电脑有什么要求?

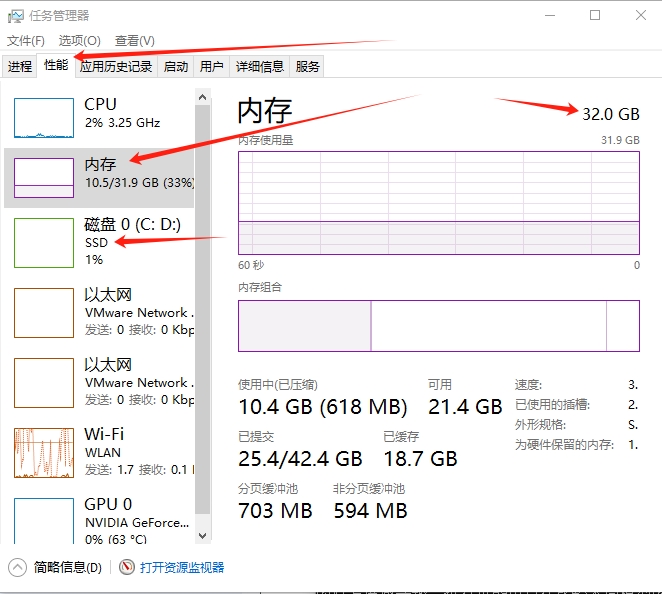

我的电脑是用来配合口扫的,跑的是DeepSeek r1:14b模型,运行比较流畅,硬件配置如下:

| 硬件名称 |

配置情况 |

| CPU |

AMD Ryzen 7 5800 |

| 内存 |

32GB |

| 硬盘 |

SSD 1TB固态硬盘 |

| 显卡/GPU |

Nvidia GeForce RTX 3070 |

基本上近两年内购买的电脑都差不多的配置。如果需要查看自己电脑的情况,可以通过下边的步骤查看。

1)同时按下电脑键盘左侧的“Ctrl”、“Shift”和“Esc”三个按键,就会跳出电脑的“任务管理器”。

2)点击任务管理器的“性能”选项卡,如下图,点击左侧的各项内容,就可以分别查看CPU、内存、硬盘和GPU(显卡)的各项参数。

请对照您电脑的情况,判断是否可以满足要求。不推荐苹果电脑,不要问我华为电脑是否可以满足要求。一切以“任务管理器”的显示和DeepSeek的要求为准。

相关参考文章链接如下,均为2025年2月6日访问:

1、关于DeepSeek公司的简介。DeepSeek(人工智能企业)_百度百科https://baike.baidu.com/item/DeepSeek/65258669

2、关于大语言模型。大语言模型_百度百科 https://baike.baidu.com/item/%E5%A4%A7%E8%AF%AD%E8%A8%80%E6%A8%A1%E5%9E%8B/62884793

3、关于开源和闭源的问题。开源大模型与闭源大模型_开源大模型和闭源大模型的区别-CSDN博客 https://blog.csdn.net/ak2111/article/details/139123479